В наше время, когда интернет доступен практически в любой момент, иногда возникает необходимость скачать сайт целиком. Зачем это нужно? Причины могут быть разные: и желание сохранить важную информацию на будущее, и необходимость получить доступ к нужным данным при отсутствии доступа в сеть, и возможность ознакомиться с тем, как сверстаны страницы. Могут быть и другие резоны. Важно знать, как выполнить эту задачу, и далее мы покажем несколько способов как сделать копию сайта для последующего его использования в оффлайн режиме.

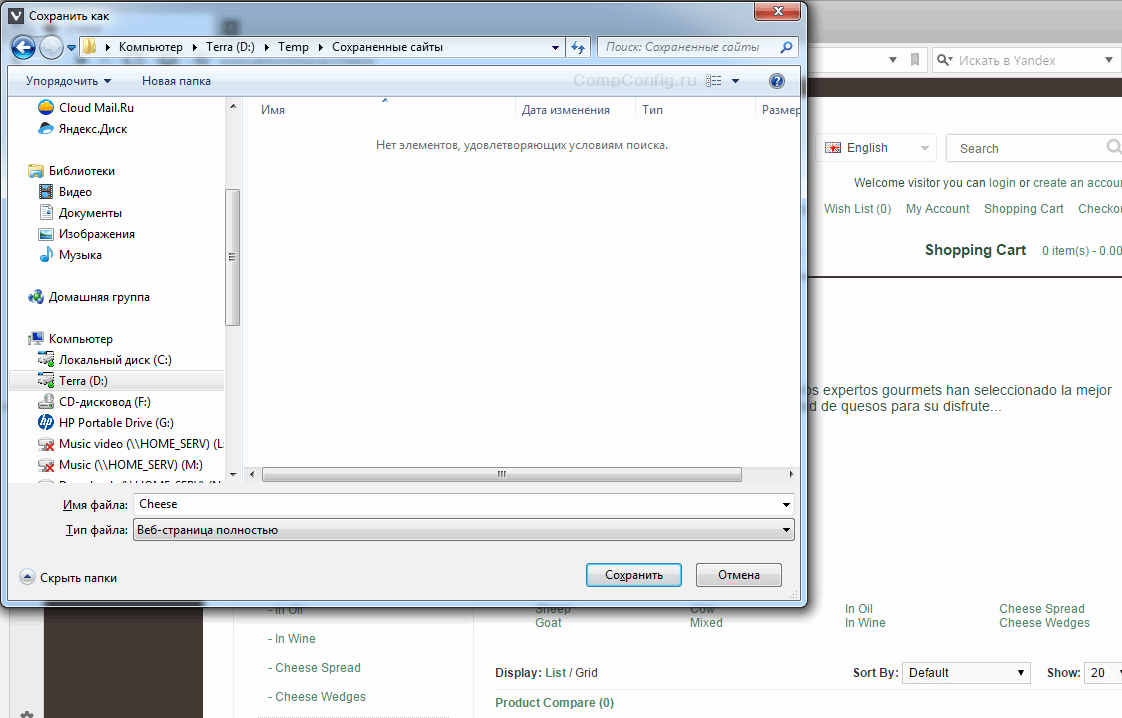

Способ 1. Постраничное сохранение

Самый простой способ о котором все знают, даже если ни разу не пользовались. Эта возможность есть в любом браузере. Достаточно лишь нажать комбинацию клавиш «Ctrl»+«S», после чего в открывшемся окне отредактировать название сохраняемой страницы и указать папку, в которую ее следует поместить.

Казалось бы, куда проще. Вот только есть в этом способе один существенный недостаток. Мы скачали всего лишь одну страницу, а в интересующем нас сайте таких страниц может быть весьма большое количество.

Казалось бы, куда проще. Вот только есть в этом способе один существенный недостаток. Мы скачали всего лишь одну страницу, а в интересующем нас сайте таких страниц может быть весьма большое количество.

Хорошо, если сайт маленький, или состоит всего из одной страницы, а если нет? Придется выполнять это действие для каждый из них. В общем, работа для усидчивых и целеустремленных, не знающих об одном из основных двигателей прогресса.

Способ 2. Использование онлайн-сервисов

Вот оно, самое простое решение. Сейчас много есть полезных онлайн-ресурсов для перекодирования файлов, редактирования аудиофайлов и т. п. Среди достоинств этого метода – кроссплатформенность, отсутствие необходимости захламлять свою операционную систему утилитами, которые, возможно, понадобятся лишь однажды.

Всего делов-то, зайти на такой ресурс, ввести в строку адрес интересующего сайта, нажать кнопку запуска процесса скачивания и подставить «емкость», в которую польется интересующая информация…

В теории так, но, к сожалению, подобных онлайн-ресурсов, позволяющих скачать сайт целиком, раз, два, три и… И, пожалуй, все, если говорить о бесплатной возможности сохранить копию сайта на компьютер. А за все остальное придется платить, или мириться с урезанным функционалом.

Но давайте рассмотрим примеры поближе.

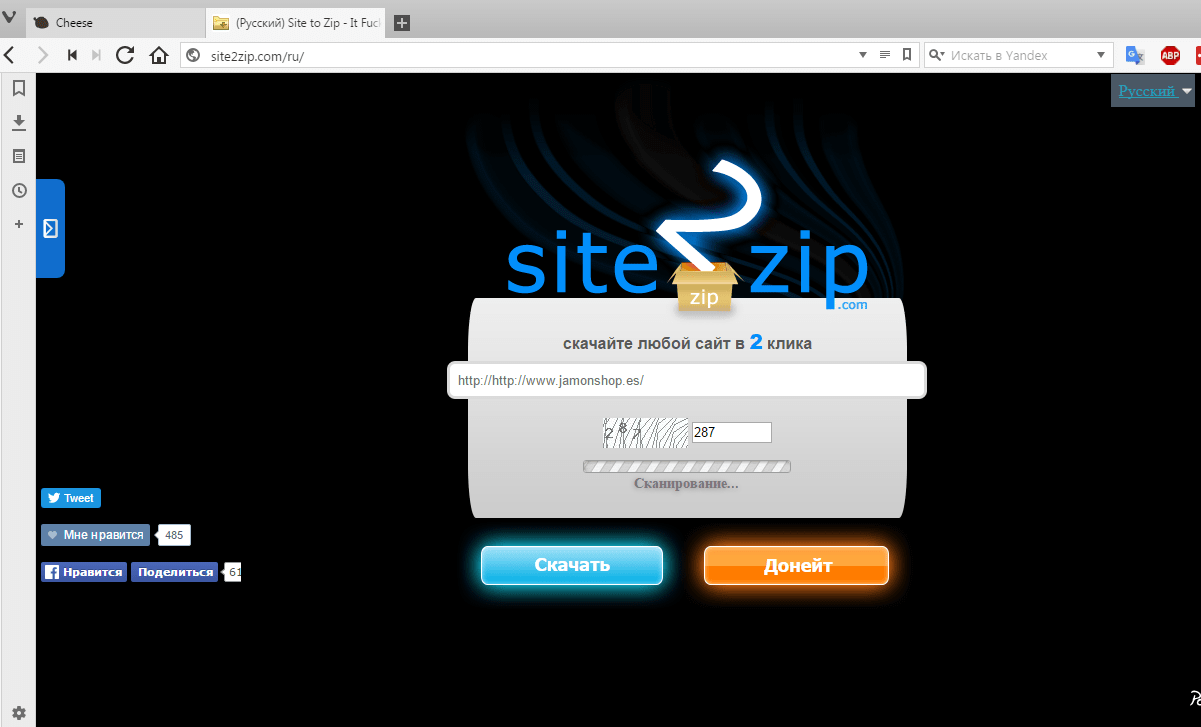

Site2Zip.com

Перестал работать в начале 2019 года.

Едва ли не единственный бесплатный и русскоязычный ресурс. Интерфейс предельно прост. В строке вводим адрес интересующего сайта, вводим капчу, нажимаем кнопку «Скачать» и ждем…

Процесс небыстрый, к тому же с первого раза может и не получиться. Если все удачно, то на выходе получим архив с сайтом.

Процесс небыстрый, к тому же с первого раза может и не получиться. Если все удачно, то на выходе получим архив с сайтом.

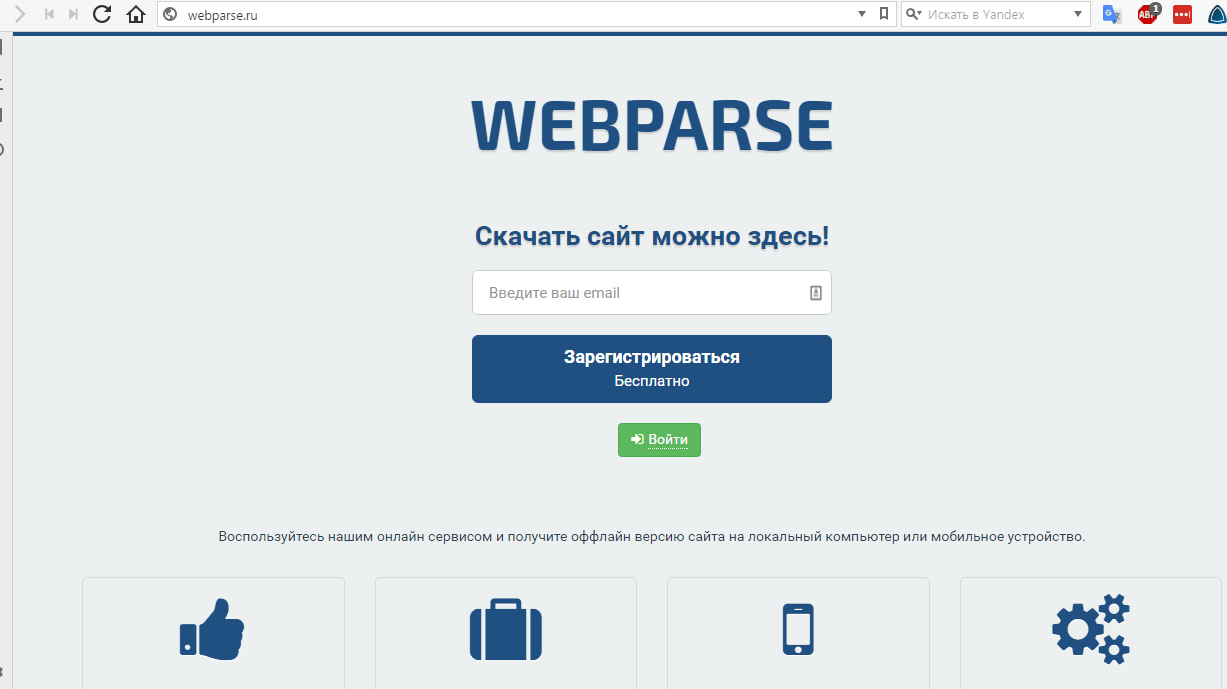

Webparse.ru

Условно-бесплатный ресурс, позволяющий один раз воспользоваться его услугами бесплатно, после чего за скачивание сайтов придется платить.

Работает webparse.ru быстрее предыдущего ресурса, но делает это не бесплатно. В итоге получаем архив со скачанным сайтом. В настройках нет настройки глубины парсинга структуры скачиваемого сайта, поэтому убедиться, что удалось скачать сайт полностью, придется только самостоятельной сверкой оригинала и его копии.

Работает webparse.ru быстрее предыдущего ресурса, но делает это не бесплатно. В итоге получаем архив со скачанным сайтом. В настройках нет настройки глубины парсинга структуры скачиваемого сайта, поэтому убедиться, что удалось скачать сайт полностью, придется только самостоятельной сверкой оригинала и его копии.

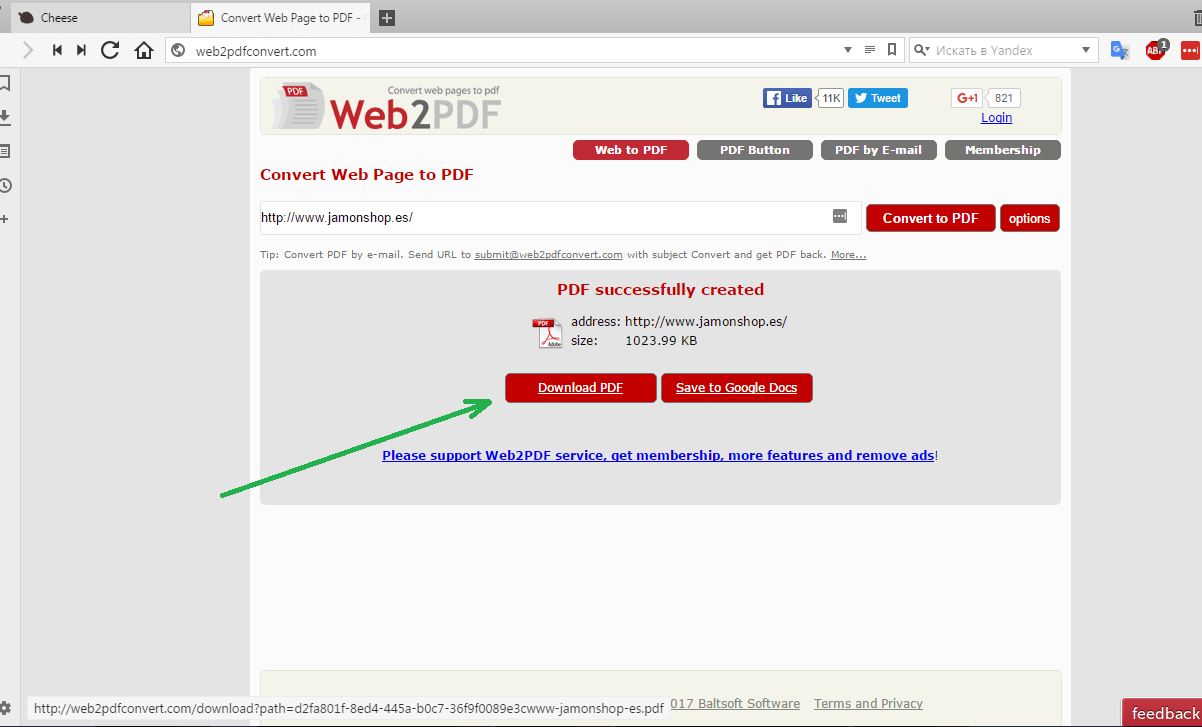

Другие ресурсы

Среди других способов можно отметить ресурс Web2PDFConvert.com, создающий PDF-файл со страницами скачиваемого сайта. Естественно, часть функционала сайта будет утеряна. Если это допустимо, то воспользоваться данным ресурсом можно.

Еще один ресурс, позволяющий скачать сайт – r-tools.org. К сожалению, пользоваться им можно только на платной основе.

Еще один ресурс, позволяющий скачать сайт – r-tools.org. К сожалению, пользоваться им можно только на платной основе.

Способ 3. Специализированные программы

Использование утилит для скачивания файлов — пожалуй, наиболее функциональный вариант, позволяющий добиться своей цели. Придется смириться с тем, что в системе появятся дополнительные программы, одна часть из которых бесплатна, а другая – более меркантильна и требует за выполнение тех же функций поощрение. Причем, бесплатные программы (иногда их еще называют оффлайн-браузерами) по возможностям практически не уступают платным аналогам.

В отличие от онлайн-сервисов, подобная программа работает гораздо быстрее, хотя придется искать подходящую под вашу ОС версию этого ПО. Некоторые программы можно найти не только для ОС Windows, но и для других.

Рассмотрим несколько примеров таких программ.

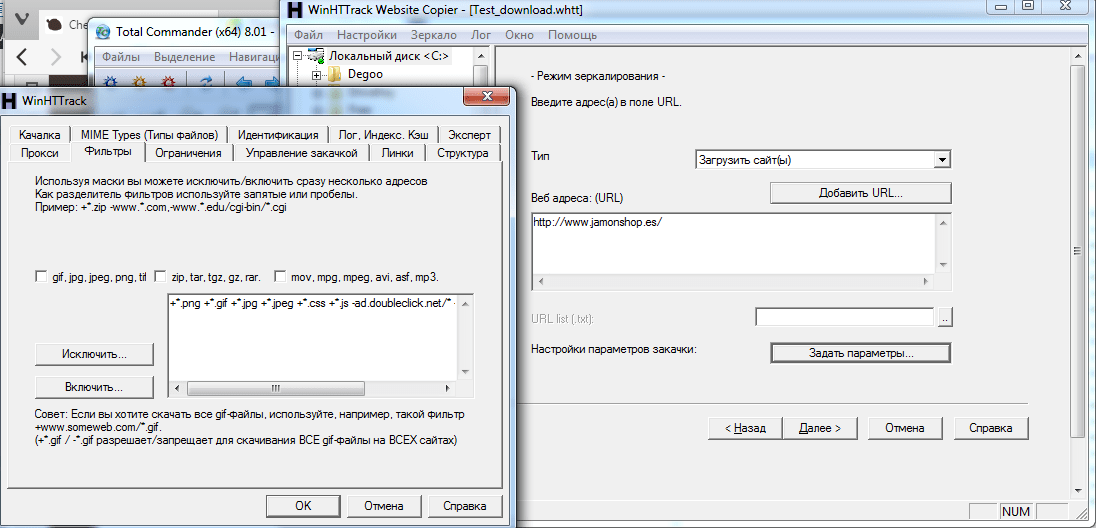

WinHTTrack WebSite Copier

Одна из самых популярных программ, предназначенных для создания оффлайн-копий сайтов. Справедливости ради надо сказать, что бесплатных аналогов практически нет.

Для того, чтобы пользоваться программой, надо скачать с сайта разработчика подходящую версию, проинсталлировать ее в свою систему и запустить. В первом окне будет предложено выбрать язык интерфейса. Среди всех вариантов есть и русский.

Интерфейс программы прост и запутаться в нем не получится. В первом окне надо указать имя и категорию проекта, а также указать место, где будет храниться скачиваемый сайт.

Теперь надо ввести адрес сайта, который надо скачать. Программа имеет большое количество настроек, где задается глубина просмотра сайта, определяются фильтры, указывающие что скачивать надо, а что – нет. Например, можно запретить скачку изображений, исполняемых файлов и т. п. Настроек много, и если есть необходимость, можно внимательно с ними ознакомиться.

Теперь надо ввести адрес сайта, который надо скачать. Программа имеет большое количество настроек, где задается глубина просмотра сайта, определяются фильтры, указывающие что скачивать надо, а что – нет. Например, можно запретить скачку изображений, исполняемых файлов и т. п. Настроек много, и если есть необходимость, можно внимательно с ними ознакомиться.

В следующем окне надо нажать кнопку «Готово», после чего остается только дождаться окончания процесса. По окончании в указанной папке будут находиться файлы скачанного сайта. Для того, чтобы открыть его для просмотра необходимо выбрать файл index.htm.

В следующем окне надо нажать кнопку «Готово», после чего остается только дождаться окончания процесса. По окончании в указанной папке будут находиться файлы скачанного сайта. Для того, чтобы открыть его для просмотра необходимо выбрать файл index.htm.

Теперь папку с проектом можно скачивать на любой носитель и просматривать там, где это удобно.

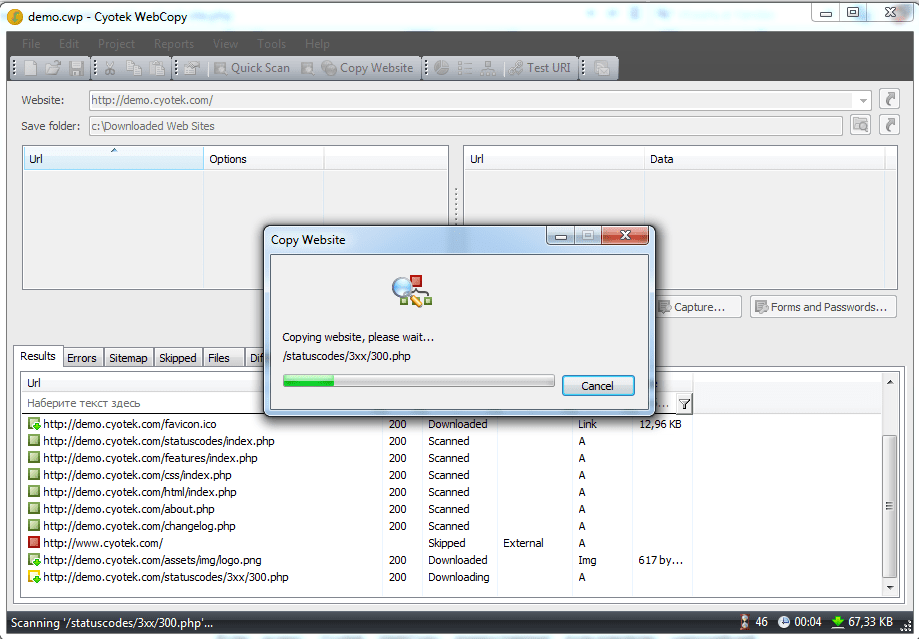

Cyotek WebCopy

Англоязычная программа с солидно выглядящим интерфейсом и большими возможностями по настройке процедуры скачивания сайта. Достаточно только вести адрес интересующего ресурса, указать папку, в которую сохранить скачанные данные и нажать кнопку «Copy Website».

Все, теперь остается дождаться окончания работы программы и в указанном места найти файл «index.htm», который и будет начальной страницей ресурса, который подготовили для оффлайн-просмотра.

Все, теперь остается дождаться окончания работы программы и в указанном места найти файл «index.htm», который и будет начальной страницей ресурса, который подготовили для оффлайн-просмотра.

Из недостатков можно отметить только отсутствие русификации, а также то, что Cyotek WebCopy работает только на ОС Windows, начиная с версии Vista. Версий под другие ОС нет.

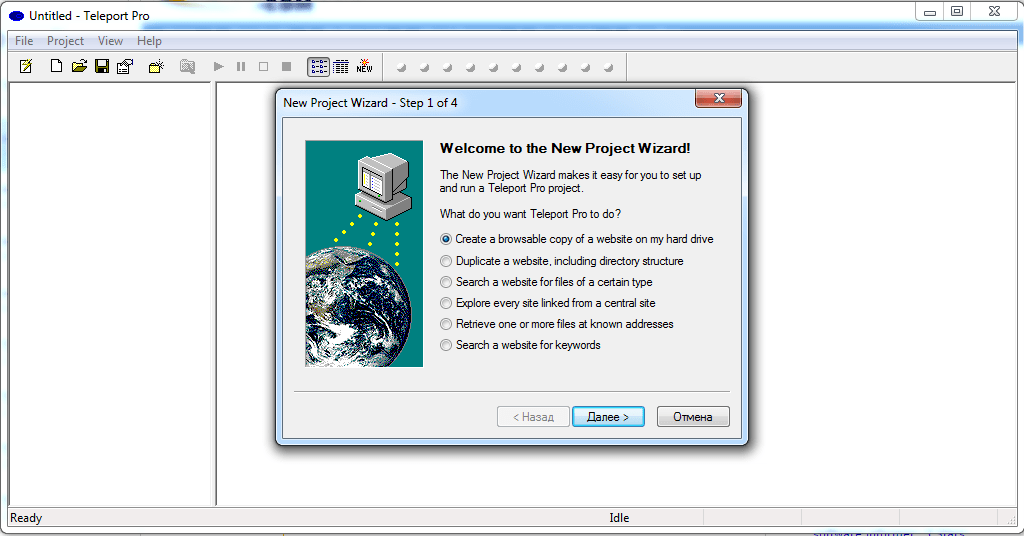

Teleport Pro

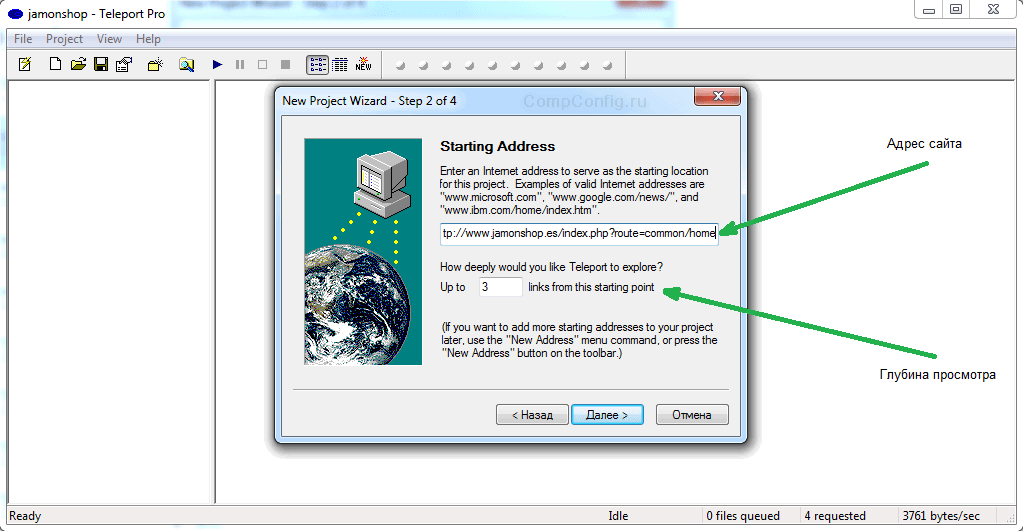

Одна из старейших программ, к сожалению, платная. Имеется тестовый период. После установки и запуска появится главное окно, где необходимо указать режим скачивания сайта. Это может быть полная копия, можно сохранить только определенный тип файлов и т. п.

После этого надо создать новый проект, который будет ассоциирован со скачиваемым сайтом и ввести адрес интересующего интернет-ресурса. По умолчанию глубина переходов по страницам имеет значение 3. Этот параметр можно изменить. После этого можно нажать кнопку «Далее».

После этого надо создать новый проект, который будет ассоциирован со скачиваемым сайтом и ввести адрес интересующего интернет-ресурса. По умолчанию глубина переходов по страницам имеет значение 3. Этот параметр можно изменить. После этого можно нажать кнопку «Далее».

Создастся новый проект, необходимо указать папку, в которую сохранять данные. Для запуска процедуры скачивания надо нажать кнопку «Start» (синий треугольник) в панели управления. Начнется процесс сохранения сайта на ваш диск.

Создастся новый проект, необходимо указать папку, в которую сохранять данные. Для запуска процедуры скачивания надо нажать кнопку «Start» (синий треугольник) в панели управления. Начнется процесс сохранения сайта на ваш диск.

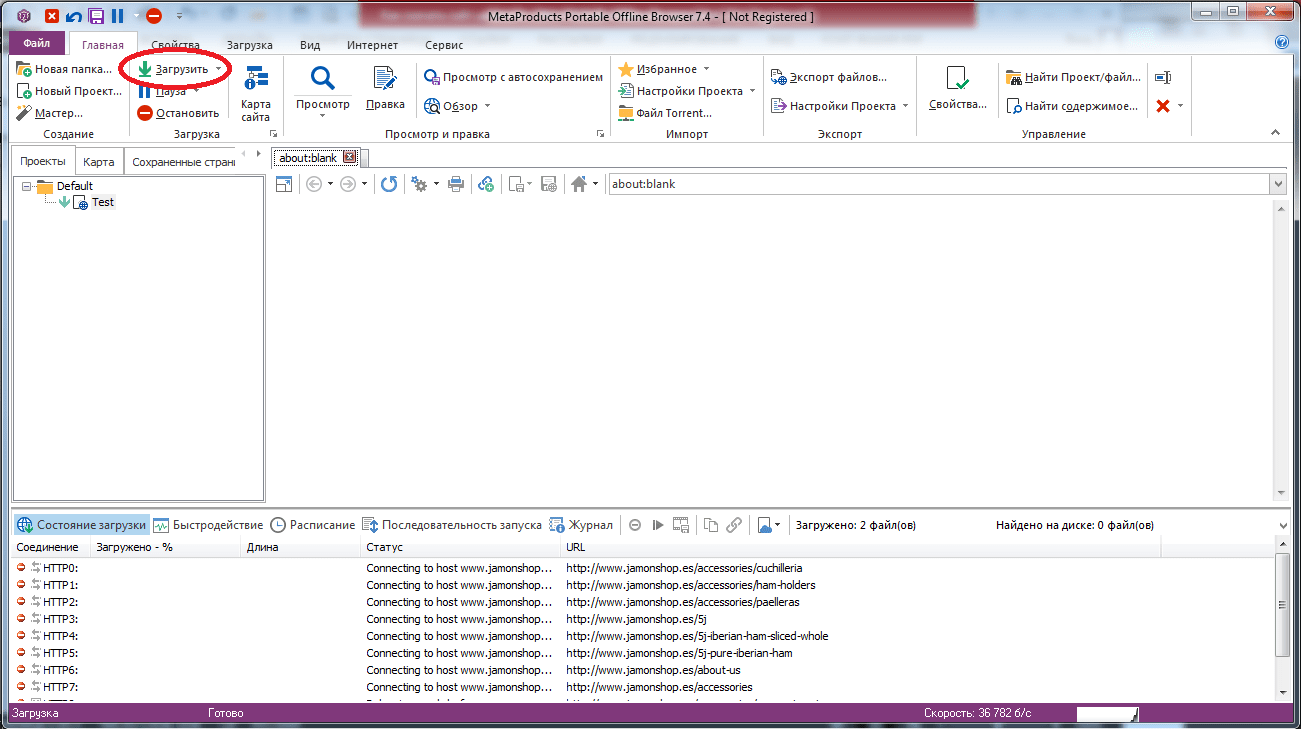

Offline Explorer

Еще одна платная, но весьма функциональная программа. Есть русифицированная версия. Триальная версия работает 30 дней, при этом есть ограничение на количество скачиваемых файлов – 2000. Программа существует разновидностях Standard, Pro и Enterprise. Самая дешевая версия стоит 59.95$, а самая дорогая – 599.95$.

Как и в других программах, работа начинается с того, что необходимо создать новый проект и указать адрес интересующего сайта. Доступно большое количеств настроек, при помощи которых можно отфильтровать ненужную информацию, задать глубину просмотра сайта и т. п.

После того как проект создан, отредактированы параметры загрузки, можно нажать кнопку «Загрузить» и дожидаться результата.

После того как проект создан, отредактированы параметры загрузки, можно нажать кнопку «Загрузить» и дожидаться результата.

Возможностей у программы действительно много. Есть многопоточная загрузка, собственный веб-сервер для просмотра того, что было скачано, масса настроек. Если оценивать все возможности, то программа действительно ценная (уж простите за тавтологию), вот только стоимость ее неприлично высока.

Возможностей у программы действительно много. Есть многопоточная загрузка, собственный веб-сервер для просмотра того, что было скачано, масса настроек. Если оценивать все возможности, то программа действительно ценная (уж простите за тавтологию), вот только стоимость ее неприлично высока.

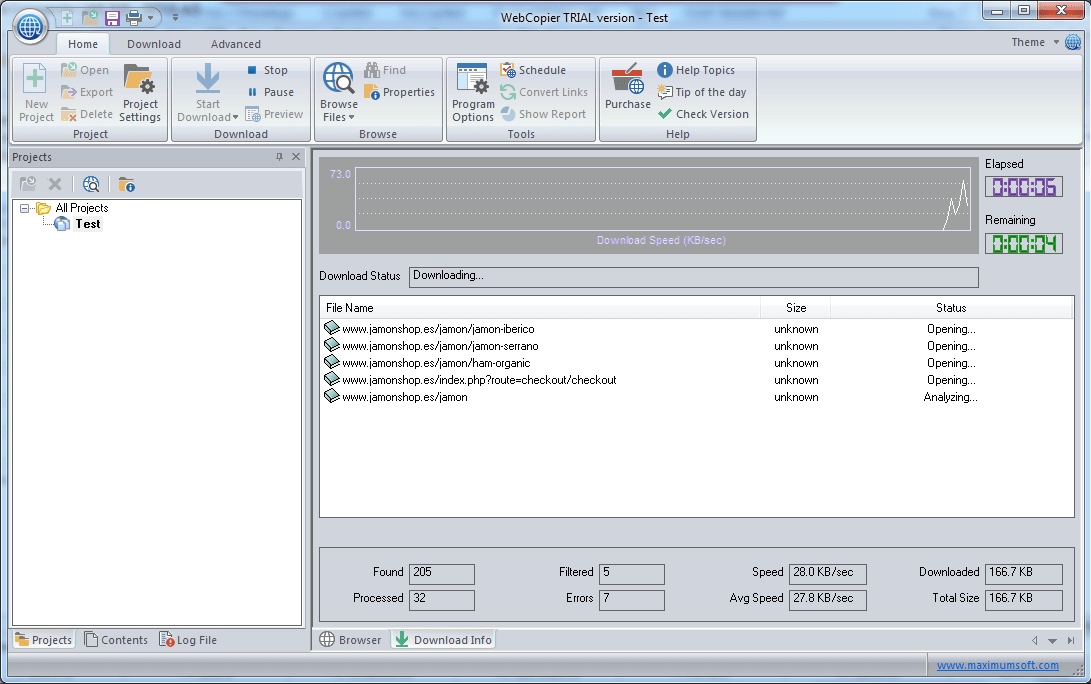

Webcopier

Платная программа с 15-дневным триальным периодом. Существует в версиях для Windows и Mac OS. Алгоритм работы не отличается оригинальностью, что, впрочем, является плюсом. Для скачивания сайта надо создать новый проект, ввести URL.

Мастер попросит ответить на несколько вопросов, например, ввести логин и пароль пользователя на скачиваемом сайте, указать папку назначения, позволит изменить некоторые параметры, например, отключить возможность скачивания изображений. После окончания создания проекта для начала процедуры создания локальной копии сайта надо нажать кнопку «Start download». Будет отображаться процесс при помощи графика, показывающего скорость работы, а также время работы.

Мастер попросит ответить на несколько вопросов, например, ввести логин и пароль пользователя на скачиваемом сайте, указать папку назначения, позволит изменить некоторые параметры, например, отключить возможность скачивания изображений. После окончания создания проекта для начала процедуры создания локальной копии сайта надо нажать кнопку «Start download». Будет отображаться процесс при помощи графика, показывающего скорость работы, а также время работы.

Заключение

Возможностей создать локальную коллекцию нужных сайтов для их просмотра достаточно. Есть и онлайн-ресурсы, есть и специализированное ПО. Каждый из вариантов имеет свои достоинства и недостатки. К сожалению, большинство программ платные, и готовы ли вы раскошелиться за более широкий функционал или достаточно того, что умеют бесплатные утилиты – решать каждому самостоятельно.

Прежде чем отдавать предпочтение тому или иному решению, следует попробовать их все, благо даже платные программы имеют тестовый период, пусть и с некоторыми ограничениями. Это позволит оценить возможности этого ПО, понять, необходим ли вам весь этот функционал, насколько корректно производится скачивание сайтов.

Самый лучший способ для меня это утилита Wget

Перепробовал много способов. Ни один не помог скачать то что хочу. На том саите что хотел бы скачать есть не только логин, но и капча. Teleport Pro например видит логин но не видит капчу. Wget ни логин ни капчу не воспринимает. А постраничное скачивание даёт возможность все скачать но переходы со страницы на страницу не получаются. Может кто даст совет как обоити капчу при скачивании???

Спасибо автору за статью! Как минимум два способа работают (webparse.ru и программка httrack). Правда, у вебпарс.ру в архиве оказалась только главная страница (index.html) и папка с картинками. Где ве остальные страницы — непонятно. Поэтому и пошёл пробовать httrack.

Большое спасибо! Мне помогла программа Cyotek WebCopy, намного проще чем WinHTTrack.

Спасибо за статью! Нужно было срочно скопировать лендинг. Нашёл вашу полезную статью, но перечисленные сервисы не подошли и пошёл искать в интернете другой. Нашёл webcloner.ru: из плюсов редактировать скопированный сайт можно прям в браузере, а из минусов это то что сервис платный.

Советую дополнить статью и расписать про wget, а то все так много о нём говорят, но ничего не объясняют.

Здравствуйте. Прошу помочь. Есть надобность в скачивании сканов книг в РГБ и Троице-Сергиевой лавре. Приходится рутинно выполнять-открыть-версия для печати-сохранить-следующая страница….Какой из вышеперечисленных ресурсов поможет скачать все рукописи махом бе этой рутины. Заранее благодарен.

Все описанные приложения позволяют скачать сайт целиком.

Как скачать страницу второго уровня с сайта, если вход на сайт по логину и паролю, которые я конечно знаю. То есть на стартовой странице нужно ввести логин и пароль для авторизации, затем кликнуть на одну ссылку и затем на вторую ссылку и вот открывшуюся страницу скачать.

Авторизуйтесь на нужном ресурсе, откройте меню браузера, выберите пункт «Страница» и «Сохранить как».

Так я умею ))

Мне нужно именно сторонним ПО, я хочу это делать регулярно, по расписанию.

ПО для такой специфической задачи вряд-ли существует, но на просторах сети можно найти самописные скрипты для сохранения веб-страниц в файл. Вот, в частности, тема на киберфоруме, посвященная такому же вопросу: http://www.cyberforum.ru/vbscript-wsh/thread2242189.html

А для запуска скрипта по расписанию можно использовать системный планировщик задач.

Просто огромнейшая благодарность за эту статью! Я получил то, что нужно! Нужно было скопировать многостраничный сайт для отчета, вот мой отзыв о опробованных способах:

1. Cyotek WebCopy — Сработал. Сделал всё, что нужно и даже больше. Вес сайта в итоге составил 151мб, весь процесс занял около 10 минут. Загрузил все картинки и прикрепленные документы, шрифты и стили. Хорошо, что дочитал до этого момента. Последняя версия 2019 года, всё бесплатно, огромный респект разработчику!

2. WinHTTrack WebSite Copier. Не получилось. В теории должен сработать, но скорость передачи файлов у меня почему-то была слишком низкая. Он пытался скачать картинку, весом 500кб около 30 секунд, а таких картинок сотни. В целом вариант может и рабочий, но мне не подошел.

3. Webparse.ru. Сохранил только главную страницу, на остальные оставил только ссылки. Предполагаю, что это отличный способ скачать лендинг.

4. Web2PDFConvert.com. Просто отказался работать. Пишет, попробуйте позже.

5. Постраничное сохранение. Самый простой и верный способ. В моем случае почему-то не скачивалась обложка в шапке, пришлось бы добавлять ее вручную. Плюс не скачиваются шрифты. В моем случае со 100+ страницами — это был бы тяжкий труд :)

Еще раз спасибо авторам статьи за такой полезный материал!

спасибо что напомнили можно через браузер скачать полностью страницу…конечно быстрее чем самому скачивать по фотке…но зато можно сделать по папкам и не сидеть и не выбирать…у меня блог на блогспоте там можно скачать все фотки подряд …он скачивает всё мешает не поймёшь где чего…самому всё восстанавливать с ума сойдёшь…

Подскажите, пожалуйста, а если нужный для скачивания сайт имеет протокол https, то его можно скачать какой-нибудь утилитой?

На сервисах из статьи про отсутствие поддержки https ничего не сказано.

Webparse.ru качает только одну страницу. Не ведитесь.

Извините, я пробовал много, но только загрузок с первой страницы.

В триальных версиях программ скачивание всего сайта может быть недоступно, но в полных должно работать.

Надо было скачать маленький сайт. Только Cyotek WebCopy справился

Cyotek WebCopy копирует хорошо, но если страниц миллион, то программа становится бесполезной. Потому как все ссылки внутри кода ведут на ссылки официального сайта и не будешь же ты миллион страниц редактировать.

WinHTTrack работает отлично,даже со смартфона…Все ссылки тоже кликабельные,но бывают и косяки конечно(по крайней мере без проблем сайт запускается на локальном сервере)…

Если кто подскажет как исправить некоторые косяки буду благодарен)))

Но эти программы не умеют загружать сайт, если сайт на htts. http сайтов почти нет.

Попробуйте скачать с помощью Wget: https://ru.wikipedia.org/wiki/Wget

Чушь, всё прекрасно тащит с https

WinHTTrack имеет ограничение в 100000 файлов, после чего останавливается, пишет «Panic, too many links.»

Не понятно, чем это обсуловлено, скорее всего разработчик идиот. Какая разница, 100к или 500к линков, действие одно и то же делается, места хватает более чем.

В общем, впустую прождал. Попробую Cyotec, если не осилит, придётся идти искать кряк для телепорт про.

Я конечно понимаю, что размер такой, да, запросы у меня серьёзные ))) Но более маленький сайт я бы и так нашёл чем стащить ))

Мое уважение таким статьям! Просто выставка годных ресурсов, аж глаза разбегаются)

Cyotek лучше справился с моей задачей, чем HTTrack